当前分类:Django>>正文

django开发的网站添加robots.txt方法一

来源:互联网

更新时间:2022年7月3日

django项目,因为是网址路由模式,所以你的项目即使部署好了后,直接往根目录添加静态文件robots.txt并不能直接访问,会提示404错误。即使你放的是一个html页面也不能直接访问,django的模式要求必须先通过路由匹配到路径地址才行。

明白了这点后,要解决这个robots.txt文件的问题就简单多了。

下面讲一下解决方法:

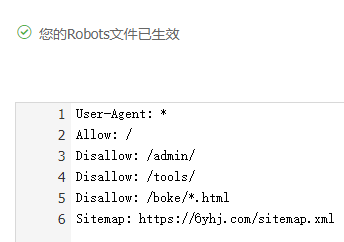

1、准备好你的robots.txt文件,并上传到模板层目录,通常是templates目录下

2、添加好路由,在urls.py文件中。如下:

path('robots.txt',views.robots,name='robots'),

3、写好视图函数,在views.py文件中,如下:

#robots协议 def robots(request): return render(request,'robots.txt')

这样设置好之后,重启一下项目就可以了。

本人亲自测试这样是成功的

但是有个站问题,就是直接访问这个robots.txt页面,是没有换行的。不过,只要百度这边能正常访问那就行了,因为这个东西本身的作用就是让百度蜘蛛知道哪些可以爬哪些不需要爬这样。

本文固定链接:https://6yhj.com/leku-p-3035.html 版权所有,转载请保留本地址!

[猜你喜欢]

- django存Cookies的方法

- PermissionError: [Errno 13] Permission denied

- cannot import name 'rnd' from partially initialized module 'peoms.tools' (most likely due to a circular import)

- django报错:KeyError: "'__name__' not in globals"

- django使用session实现对post查询请求数据的分页

标签: