python爬虫伪装成浏览器访问

python爬虫技术中重要的一项就是伪装,如果你直接用python中requests或者urllib这些库去请求网站内容,是很容易被拒绝的,这时候你能得到的基本上都是一个408或者其他错误的提示。

为什么?因为爬虫来访基本上是爬取网站内容的,而且还会消耗服务器资源,没有哪个网站会喜欢。

伪装就变得相当重要了,有了伪装技术,一个爬虫大佬基本上可以做到无所不爬,任凭你有什么反爬技术。

今天给大家说一下爬虫入门的伪装技术:伪装成浏览器访问

伪装成浏览器,只要做一件事就行了,就是在你的请求头信息里面,添加一个User-Agent信息就行了。

问题是这个user-agent信息如何找到呢?

我们下面来举个例子:伪装成使用谷歌浏览器访问百度的爬虫

步骤如下:

我们先在自己电脑上安装一个谷歌浏览器,然后打开百度首页

点击右键,点击“检查”

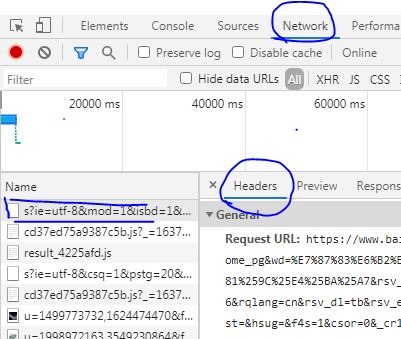

然后按下图,依次点击左边的链接,再点击上面的“network”、 “headers”

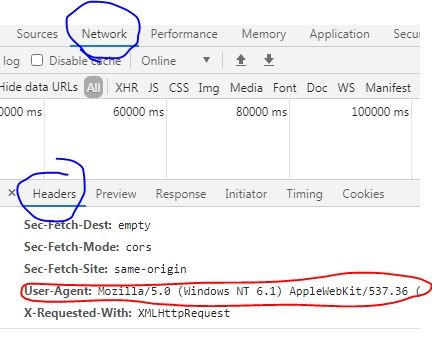

然后再往下面拉,不出意外你就可以看到一条user agent的信息,那个冒号后面对应的就是你的谷歌浏览器的信息啦

把这个条信息复制下来。

接下来你就可以写一条这样的爬虫,它就是伪装成浏览器进行爬取网站内容的。

python3.10

import requests

webl=r"http://baidu.com"

#复制来的信息就放在下面的括号里面

headers={

"user-agent":Mozilla/5.0 (Windows NT 6.1) AppleWeb\

Kit/537.36 (KHTML, like Gecko) Chrome/87.0.4280.88 Safari/537.36

}

r=requests.get(webl,headers=headers)

刚才上面就说了,这种操作只能算是爬虫的入门操作,如果有网站真的做了反爬设置,我们还需要做很多的调整,在请求头headers里面添加更多的参数信息才行。

要伪装在手机访问也是可以的,可以看下怎么获取手机浏览器user-agent,还可以添加代理ip之类的。

- Python deque:高效双端队列操作

- 使用Python的Tkinter模块创建图形用户界面(GUI)

- Python列表操作:提高数据维护和快速查询

- Python输入函数:接收控制台输入的数据

- Python实例:创建类的实例

标签: